Часто люди не понимают, почему к ним не поступает трафик. Одной из причин может являться плохая индексация. Основным же признаком этого, является отсутствие в результатах выдачи. В этой статье мы разберем основные причины, почему так может происходить.

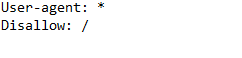

1. Блокировка в robots.txt

Нередко, особенно при создании сайта, разработчики отключают его от индексирования в файле robots.txt, чтобы поисковые системы не успели проиндексировать неготовый сайт с его возможными ошибками. А после создания, иногда, они просто забывают его открыть.

Так же, просто плохо настроенный robots, может не давать индексировать. При проблеме с индексацией – в первую очередь смотрим этот файл. Сделать это мы можем, дописав к своему сайту /robots.txt.

Заблокированный сайт, чаще всего выглядит так:

Необходимо удалить вторую строчку, которая как раз означает запрет.

Если же вы хотите узнать больше– можете прочитать нашу другую статью

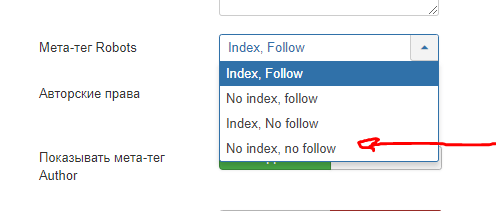

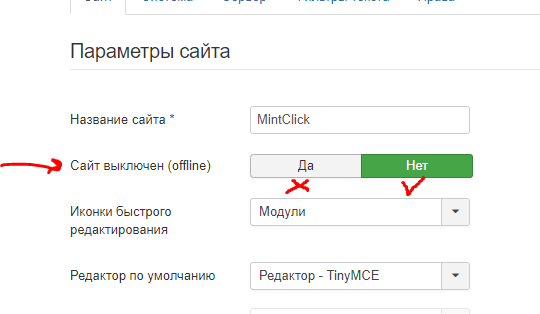

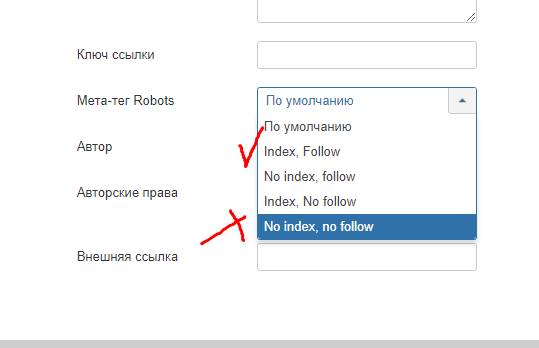

2. В CMS включен режим невидимки.

Этот режим нужен для того-же, для чего закрывают в robots – отключить индексацию на время разработки. Только это делается в самой CMS.

Например, в Joomla можно закрыть в общих настройках:

Для индексации должно стоять Index, Follow.

Там же есть возможность полностью отключить веб-сайт. Проверьте чтобы он был включен для пользователей.

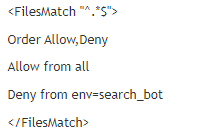

3. В .htaccess установлен редирект или доступ закрыт специально

Далее нужно проверить файл .htaccess, который обычно находится в главном каталоге.

Там есть несколько вариантов, как можно заблокировать индексирование.

Заблокировать специально можно прописав там такие строки:

SetEnvIfNoCase User-Agent "^Googlebot" search_bot - за место Гугла может быть любой другой бот. Правило в целом присваивает боту Гугла значение “search_bot”, которое в дальнейшем блокируется другим правилом:

Следовательно, чтобы разрешить роботам индексировать – эти строки надо удалить.

Так же может быть прописан 301 редирект или прописаны 403 или 410 ответы сервера. В этих случаях индексации не будет.

Нужно сказать, что такое встречается крайне редко, поэтому это можно проверять в случае, если вы подозреваете, что кто-то мог вам специально закрыть веб-сайт, имея к нему доступ.

4. Мета тег robots в коде.

Индексацию можно закрыть, вписав на страницу < meta name=”robots” content=”no index, nofollow” >

При подозрении, что какая-либо страница не индексируется поисковыми системами – проверьте, есть ли на ней этот мета-тег и удалите его, если есть. Данный тег обычно ставят на каких-то технических страницах, который по каким-то причинам не был заблокирован в robots.txt. Обычно он ставиться в CMS, которая не предусматривает правки файла robots.txt.

5. Отсутствующий или не обновленный sitemap.xml

Ускорить индексирование, может помочь корректный и своевременно обновляемый sitemap.xml. Обычно он автоматически генерируется CMS системой. Посмотреть его вы можете дописав /sitemap.xml к адресу веб-сайта. Например, https://mintclickseo.ru/sitemap.xml

Если такого функционала нет – можете формировать этот файл вручную или же используя сторонние сервисы для автогенерации.

Он специально предназначен для более быстрого индексирования. Больше информации вы можете получить в статье

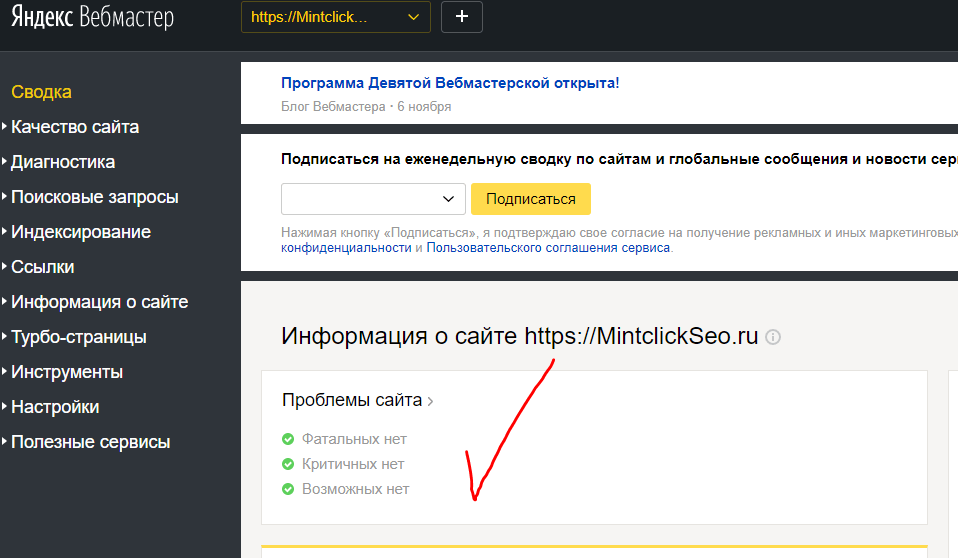

6. Сайт отсутствует в Яндекс Вебмастере и Google Search Console

После создания сайта, старайтесь сразу добавить его в эти два сервиса, это даст прямое указание поисковым системам, на то, что веб-сайт создан и готов к индексации.

После некоторого времени, данные сервисы начнут индексацию, а также укажут на имеющиеся проблемы.

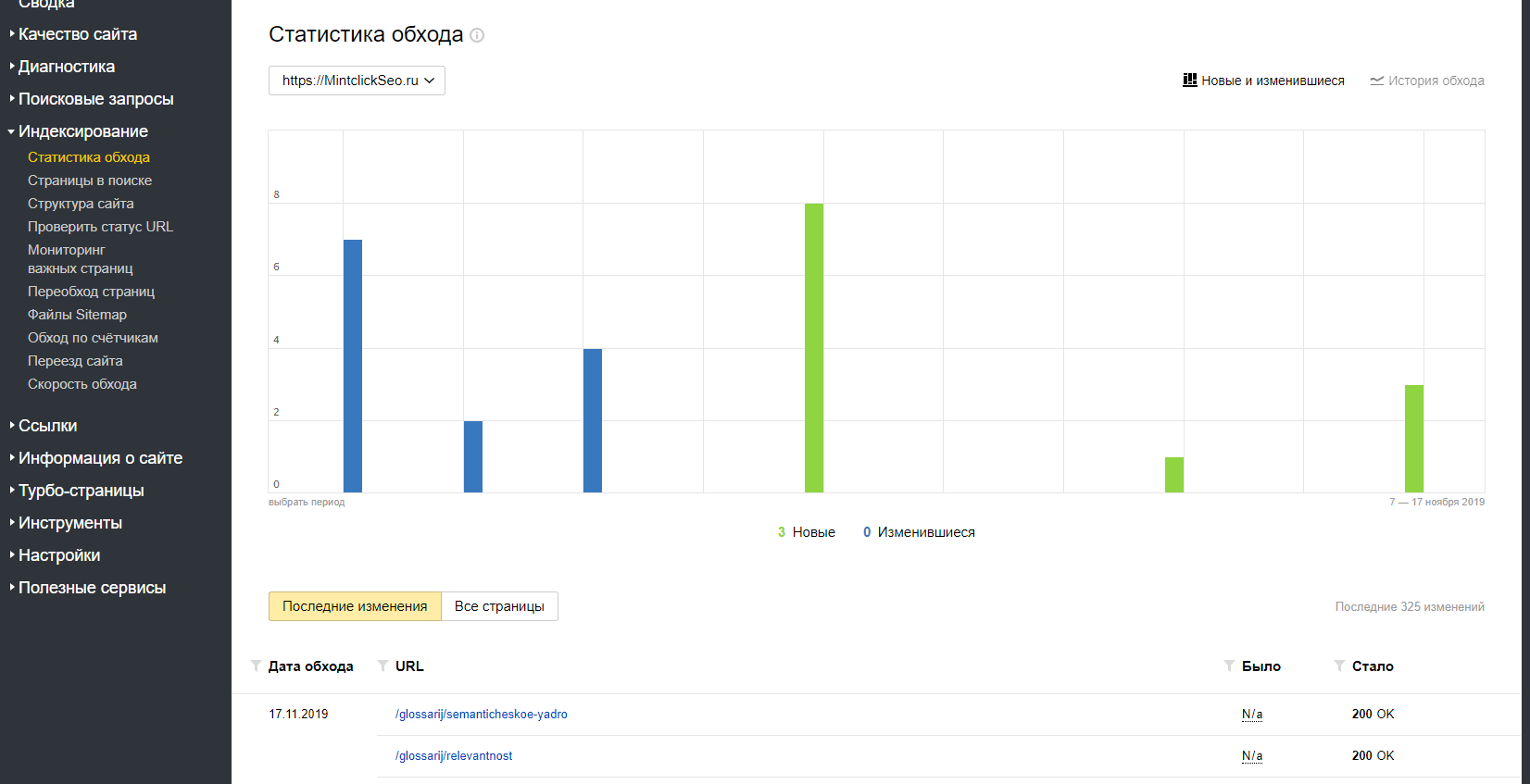

Тут же в вебмастере, в разделе индексирование, можно найти все ваши страницы, которые участвуют в поиске. Это довольно удобно т.к. вы знаете какой контент “одобрен” Яндексом, а где, возможно, стоит поработать.

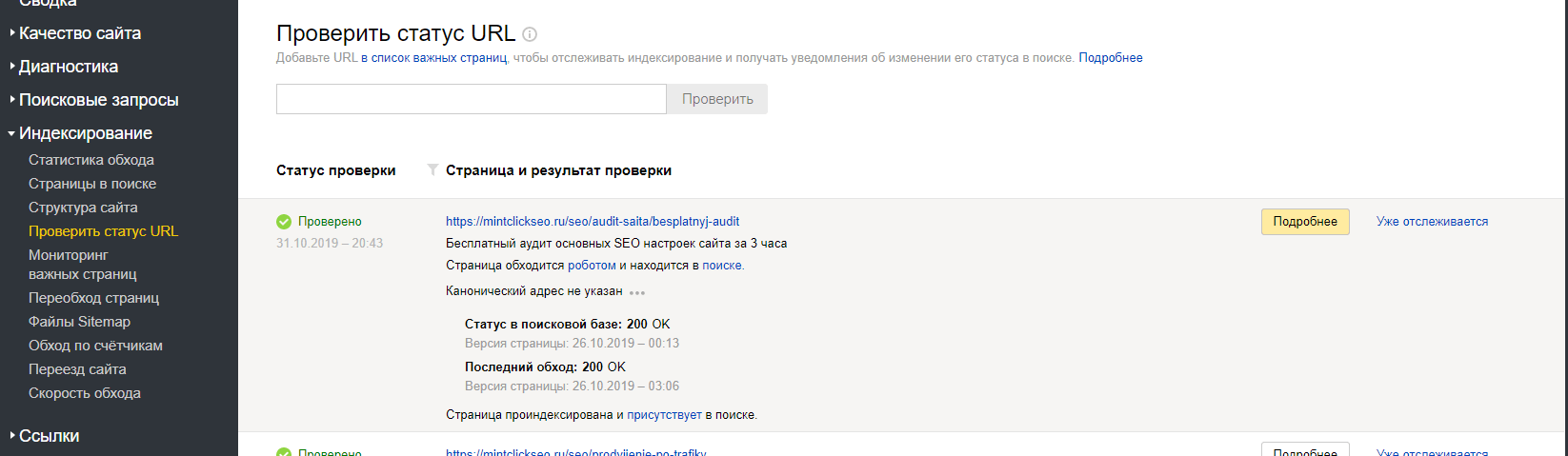

Вы можете следить за общей информацией о всех страницах и их кодах ответа, или же вы можете узнать статус отдельно взятой страницы, указав ее ссылку в разделе проверки статуса URL.

7. Технические проблемы

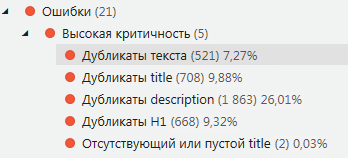

Не секрет, что поисковики не любят веб-сайты, на которых куча проблем, таких как битые ссылки, дубликаты текстов, мета тегов. Так же некорректные редиректы, низкую скорость загрузки, долгий ответ сервера итд

Поэтому если ваш веб-сайт не индексируется – проверьте, возможно поисковики не хотят индексировать из-за большого количества ошибок.

Эти ошибки можно найти используя специальный софт. Далее их необходимо исправить. Это очень важно т.к. исправив ошибки, можно хорошо продвинуть веб-сайт среди конкурентов.

Также нужно уделять большое внимание мобильной версии т.к. люди все чаще используют именно смартфоны, для поиска чего-либо. Поэтому внимательно следите, чтобы ваша версия была без ошибок, загружалась быстро и была удобной пользователю. И тогда поисковики это оценят и поднимут ваш веб-сайт в выдаче.

8. Индексируемость приостановлена самим поисковиком

Такая проблема может возникнуть в основном, если вы уже пытались продвигаться не совсем честным способом. Тогда могут быть наложены санкции, или по-другому - сайт попадет под фильтр. Как итог – он может перестать быть видимым.

Обычно в Вебмастере Яндекса будет написана причина “бана” и вы сможете исправить все нарушения и тогда через некоторый промежуток времени Яндекс рассмотрит, как вы все исправили и если все хорошо – вернет веб-сайт в поиск.

В Гугле, к сожалению, такой возможности нет и вам самим придется все выяснять.

Чаще всего причинами бывают всевозможные накрутки поведенческих, вредоносный код, нерелевантный или скопированный контент, SEO ссылки, заспамленность ключевыми словами или фразами и т.п.

Делайте качественный контент и не прибегайте к черным методам продвижения, и вы избежите данных неприятностей.